Klienci często pytają Mnie „co tak naprawdę dostaję w audycie SEO”. Moi sympatyczni konkurenci (czytaj: koleżanki i koledzy z branży) też wielokrotnie pytają co i jak ma się znaleźć w takim dokumencie. Zbierając wszystko razem postaram się to w kilku „krótkich” słowach opisać krok po kroku co może znaleźć się w audycie. Na pewno nie wyczerpię wszystkiego ponieważ audyt SEO powstaje indywidualnie dla każdej witryny z tego powodu, że każda jest inaczej zbudowana. Ale cechy wspólne na pewno są.

Audyt SEO – Przygotowanie do audytu

Jak siadasz do audytu to lepiej od razu wstań… nie warto rzucać się od razu do wykonania analizy. Najpierw należy zacząć od ….

Wskazówki dla webmasterów według Google … aaaaale żarcik 😉

Obejrzyj i poklikaj w serwisie

Zanim tak naprawdę zaczniesz audyty seo i rozpoczniesz szukanie błędów w serwisie najpierw należy „poużywać” go jako zwykły użytkownik wchodząc we wszystkie linki, wyszukując rożnych rzeczy (o ile jest wyszukiwarka – najczęściej w sklepach i dużych serwisach). Należy obejrzeć czy serwis działa szybko, czy wolno, jak się ładują strony, czy jest wygodna nawigacja (o której pewnie tutaj nie napiszę bo to SEO a nie marketing), posprawdzać czy serwis ma zaimplementowane przekierowania, poprawnie zwraca strony z błędami (404) czy się zawiesza dając error500 ? Można też przynajmniej wzrokowo popatrzeć czy serwis ma teksty wytłuszczone, powiększone (tutaj podejrzenie pada na H1, H2, H3)…

Pewnego rodzaju udogodnieniami są narzedzia dostępne na rynku… sam korzystam z kilku: opisywanego juz na blogu Seoptimer oraz od jakiegoś czasu Screaming Frog SEO Spider Tool (bardzo fajne narzędzie – wersja darmowa daje możliwość analizy kilku podstawowych czynników – polecam). Screaming Frog szczególnie przydaje się do wyłapywania pustych stron, stron z błędami – czyli tego co Google nie lubi przy indeksacji.

Co dać robotom …

… do indeksacji. Tutaj można spotkać wiele różnych opinii. Dla Mnie istotna kwestia jest:

- jakie roboty wpuścić, jakie zablokować

- co im dać do indeksowania

De facto wpuszczać należy Google 😉 a blokować wszystko co zżera transfer (np: Yandexa, Baidu i inne robociki uznane popularnie za pazerne).

W kwestii co blokować do indeksacji to należy zablokować: skrypty javascriptów, css, obrazki (jeśli tego wymaga sytuacja), ciasteczka, zablokować indeksowanie znacznika sesji (powoduje duplikację stron).

Spójrz do Webmaster Tools oraz statystyk

Jeśli klienta strona jest podłączona do Google Webmaster Tools należy poprosić o dostęp i sprawdzić co tam piszczy. Niejednokrotnie ułatwia Mi to życie oraz analizę – widać od razu co jest do poprawienia (błędy HTML, błędy indeksacji), jakie słowa kluczowe są wysoko, jakie nisko, skąd pochodzą linki …i tak dalej. Dobrze jest też zerknąć do statystyk (np Google Analytics). Audyt SEO bez dostępu do panelu narzędzi jest możliwy ale dobrze tam zerknąć.

Co analizujemy przy audycie SEO

Właściwa analiza składa się z pięciu sekcji, które należy sprawdzić i opisać:

- Dostępność

- Indeksacja

- Czynniki na stronie (on-site factors)

- Czynniki poza serwisem (off-site factors)

- Analiza konkurencyjności (rzadko wykonywana ponieważ jest kosztowna i klienci się na nią nie decydują)

Dostępność

Jeśli chodzi o dostępność to analizie podleagają następujące sprawy:

Plik robots.txt

Plik robots.txt jest używany do sterowania zachowaniem się robotów indeksujących nasz serwis. Możemy zabronić albo zezwolić na indeksację poszczególnych elementów serwisu. Ze swej strony powiem tylko, iż często spotykam się z problemami poprawnej konfiguracji tego pliku.

META Tagi dla robotów

Jest to bardzo istotny tag META – pozwala sterować indeksacją poszczególnych podstron serwisu. Szczególnie przydatny w sklepach internetowych gdzie powstaje sporo podstron, których indeksacja jest niepotrzebna (np. regulaminy, koszyk, rejestracja klientów, logowanie…).

404, 500 …

Należy odszukać i poprawić zachowanie serwisu dla błędów zwracanych wyszukiwarkom – błędy 404 (brak strony) powinny pokazywać konkretną informację wraz z odnośnikami do kilku podstron serwisu. Jeśli serwis działa niepoprawnie zwracać może błąd 500 o niedostępności – wyszukiwarki tego nie lubią i potrafią „otagować” serwis jako sprawiający kłopoty i przesunąć go w wynikach wyszukania na dalsze pozycje.

XML Sitemap

Jest to dokument, dzięki któremu robociki wiedzą co, gdzie indeksować. Jednocześnie dzięki temu plikowi indeksacja następuje dużo szybciej. Brak tego pliku „prawie” uniemożliwia robotom śledzenie zmian w sklepie.

Ten plik podlega pewnym prawom:

- czy jest prawidłowo zbudowany – trzeba to sprawdzić gdyż zdarza się, że składnia jest niewłaściwa i np Google potrafi taki plik wtedy pominąć

- sitemap’ę należy dodać w centrach Webmatser Tools aby wskazać wyszukiwarcę, ze taki plik istnieje i aby podążała najpierw do niego w celu lepszej indeksacji serwisu

- zawsze plik nalezy aktualizować po dodaniu nowej strony czy tez produktu – klienci (zwłaszcza właściciele sklepów) nie przywiązują do tego wagi

- jeśli usuwamy jakieś produkty czy stronę – taka podstrona serwisu MUSI zniknąć z pliku sitemap

Osobiście dla swoich katalogów (z racji ich wielkości) staram się aby plik sitemap był aktualizowany raz na 2-3 tygodnie.

Architektura serwisu

Wbrew pozorom jest do bardzo istotny czynnik. Szczególnie ważne jest to przy sklepach internetowych oraz dużych, rozbudowanych serwisach.

Łatwiej jest zapanowac nad strukturą płaską:

strona główna : kategoria produktów : produkt właściwy

niż nad rozbudowaną:

strona główna : kategoria : podkategoria : jeszcze jedna podkategoria ..... : strona produktu

Wpływa to na prędkość indeksacji, łatwość pozycjonowania (im „głębszy” serwis tym gorzej może się go pozycjonować), wyszukiwarki nie lubia tez indeksować długich adresów URL. Przykładem mogą być katalogi stron, których zagłębienie kategorii może być bardzo duże. Naprawdę nie warto budować takiej struktury. Choć nie ukrywam, że czasem nei ma od tego ucieczki.

Flash i Javascript

Proszę unikać stron wykonanych w całości bądź w większej ilości we flashu. Oczywiście bardzo ładnie to wygląda ale pozycjonowanie i indeksacja flash’a jest „praktycznie” niemożliwa. Podobnie sprawa ma się z Javascript’em – widziałem ostatnio stronę, która w całości była wykonana w tym „czymś” – po wyłączeniu w przeglądarce obsługi javascriptu strona stała się nieczytelna. W związku z tym uczulam: mało TAK, dużo NIE !!!

Wydajność strony

Tutaj sprawa jest prosta: im dłuzej strona się ładuje tym bardziej „wnerfionego” klienta masz przed ekranem i tym szybciej ucieknie z Twojego serwisu.

Google Page Speed pozwala CI sprawdzić wydajność, prędkość ładowania Twojej strony – sprawdzenie swojego serwisu jest szybkie – dostaniesz konkretne wskazówki co i jak poprawić.

Indeksacja serwisu

Trzeba rozejrzeć się w wyszukiwarkach jak jest zaindeksowany serwis. Wiadomo, że najważniejszy jest Google więc sprawdźmy:

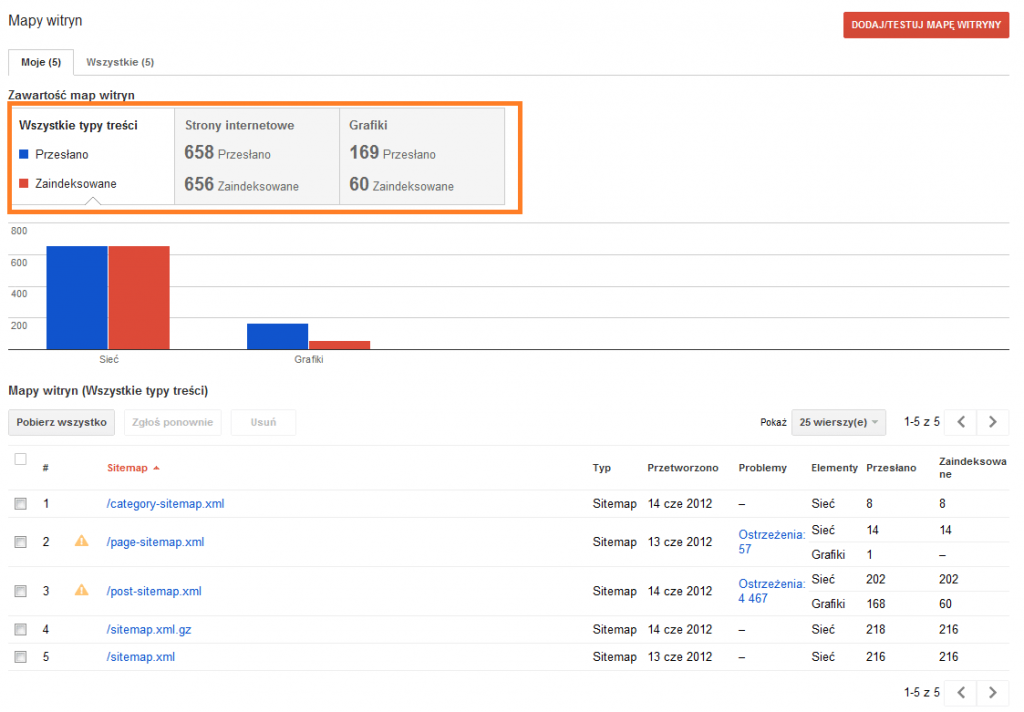

- zaglądamy do Google Webmaster Tools i sprawdzamy co i jak jest zaindeksowane – idealnie jest gdy mamy równa sobie liczbę linków zgłoszonych do zaindeksowanych

I tutaj mamy dwa scenariusze:

- jeśli liczba linków zaindeksowanych jest DUŻO większa niz prawdziwa liczba linków w serwisie to może (podkreślam może) oznaczać, że cos jest źle – czyli mamy duplicate content w obrębie witryny np poprzez zmiennie dynamiczne zmienaine TITLE (jedna z firm seo to stosuje … witki opadają)

- jeśli liczba linków zaindeksowanych jest DUŻO mniejsza od liczby linków w serwisie to może (podkreślam może) oznaczać, że podstrony tego serwisu są słabo, źle albo wcale podlinkowane lub zawierają takie błędy, ze trafiły do supplementala

Sprawdzić należy też czy są zaindeksowane wyniki wyszukania – jeśli tak – zablokować. Pisałem o tym tutaj.

Filtry, kary od Google

Tutaj to jest temat rzeka. Klient zgłaszający się po audyt z reguły już ma jakąś nałożona karę. To co można sprawdzić to:

linki – jakość, sposób pozyskiwania, działanie konkurencji, SWL-e

zawartość – czy są zduplikowane artykuły w i poza serwisem, czy produkty są dodane do porównywarek

i tak dalej – nie będę się rozwodził ale na fakt kar i dzięki wywiadowi od klienta możemy podjąć działania , które pomogą nakreślić kolejne etapy działania z witryną.

Czynniki na stronie (on-site factors) – ważny aspekt audytu SEO

Do tej pory, mamy analizie dostępności i poziomu indeksacji witryny. Teraz nadszedł czas, aby zwrócić uwagę na charakterystykę stron witryny, które wpływają na jej ranking w wyszukiwarkach.

Ogólnie rzecz biorąc, analiza strony jest przydatna do identyfikacji konkretnych przykładów możliwości optymalizacji i analiza na poziomie domeny pozwala określić jak nakład pracy jest niezbędny do dokonania korekty całego serwisu

Adresy URL

- Czy adres URL jest krótki i przyjazny dla wyszukiwarki ? Długość adresu max. 115 znaków

- Czy adres URL zawiera interesujące nas słowa kluczowe ? Jest to ważne aby słowo/słowa kluczowe znajdujące się w adresie URL odpowiadały i były związane z tekstem na stronie

- Czy adresy są oparte na strukturze poddomenowej czy podkatalogowej (foldery) ? Zgodnie z zaleceniami Google podkatalogi (foldery) stosuje się wtedy kiedy wszystkie części serwisu są ze sobą zbieżne tematycznie. Jeśli nie – stosujemy poddomeny.

- Czy URL zawiera jakieś zbędne znaki, parametry czy inne „podjerzane” elementy mogące wpływac negatywnie na SEO ? Najlepiej unikać wszelkich zbędnych ozdobników, parametryzacji, przekazywania sesji, sortowania i tak dalej …. Parametry i inne rzeczy można zablokować w Google Webmaster Tools.

- Czy adresy URL używają jakichkolwiek znaków do oddzielenia słów kluczowych ? Tutaj mamy dwie szkoły: podkreślenie i myślniki. Osobiście nie mam nic przeciwko podkreślnikom ale myślniki (minusy) lepiej wyglądają i łatwiej się je czyta.

Zawartość czyli treść

Tak naprawdę powinno się „przebadać” cały serwis jednakże niejednokrotnie wystarczy „rzut oka” i sprawdzenie kilku podstron aby wiedzieć czy i jakie błędy zostały popełnione.- Czy treść jest wystarczająca ? Tak naprawdę nie ma minimalnej i maksymalnej długości treści co do której wyszukiwarka podejmie decyzję czy i na ile jest on wartościowy. Wiadomo, że ma być pod użytkownika (hehehe) … no ale wiadomo, że im dłuższy tym lepszy bo można przekazać więcej informacji 😉

- Czy tekst jest wartościowy dla użytkownika, który odwiedza stronę ? Tutaj wiadomo, ma to być artykuł dzięki któremu zainteresujemy czytającego … W sklepach jest to opis produktu, więc opis musi być zrozumiały (jeśli techniczny) zwięzły i czytelny. Nie może to być papka słów, bo stracimy potencjalnego klienta na zakupy.

- Czy opis, artykuł zawiera słowa kluczowe, które są pozycjonowane ? Czy te słowa pojawiają się w tak zwanej zajawce ? Majac serwis z artykułami skonstruować tekst z zajawkami jest łatwo. Niestety przy sklepach jest to prawie niemożliwe. Stąd tutaj de facto należy się skupić na fakcie aby słowo/fraza była w opisie produktu.

- Spam w artykule, opisie (np., keyword stuffing)? Upychanie słów nie służy i to bez względu gdzie to nagromadzenie słów się znajduje.

- Profesjonalizm w opisie – czy jest? Opis nie powinien zawierać błędów i być dostosowanym do prezentowanego produktu. Tutaj wskażę jedną ciekawostkę – użytkownicy dodający komentarze często popełniają błędy i przestawiają literki – nie poprawiać tego ponieważ daje to efekt „naturalności” w komentarzach (nic nie podpowiadam po co to napisałem 😉 ).

- Czy zawartość strony jest czytelna ? Wiadomo, że nieciekawy i niezbyt dobrze widoczny artykuł powoduje „ucieczkę” klienta – dobre rozmieszczenie tekstów na stronie (czyli dobry projekt strony) to podstawa.

HTML … czyli co w trawie tak naprawdę piszczy ?

Tytuł – TITLE

- Czy tytuł jest zwięzły ? Tytuł strony powinien maksymalnie składać się z 70 znaków. I nie należy tej granicy przekraczać bo potem serwis „dziwnie” jest zaindeksowany.

- Czy tytuł właściwie opisuje zawartość strony ?

- Czy tytuł zawiera pozycjonowane słowo kluczowe oraz czy znajduje się na początku ? Tytuł strony MUSI (a przynajmniej powinien) zawierać pozycjonowane słowo kluczowe.

META DESCRIPTION, KEYWORDS

Obrazki – czyli ALT

Linki wychodzące

- Czy linkujesz do wartościowych stron ? Nie powinno się linkować do stron, które potencjalnie mogą być uznane za spamerskie.

- Czy linkujesz do strony zbieżnej tematycznie ? Tutaj oczywiście poruszony jest temat rzeka i praktyka wielu szkół – czy należy linkować tematycznie ?

- Czy anchor zawiera tekst i jeśli tak to czy zawiera słowa kluczowe związane ze stroną docelową oraz czy dany anchor znajduje się na stronie docelowej w postaci tegoż słowa ? STaramy się unikać Google bombing czyli pozycjonowania słów, które nie występują na stronie docelowej

- Czy strony docelowe są aktywne ? Jeśli strony docelowe zwracają błąd 4xx lub 5xx powinno się je zdejmować. nic tak nie wkurza klienta, gdy strona docelowa nie działa – wtedy naszje strony nie postrzega jako wartościową (podobnie jak wyszukiwarka)

- Czy strony docelowe używają przekierowań ? Jeśli linki wewnętrzne (podkreślam wewnętrzne) używają przekierowań należy zadbać aby były one poprawnie wykonane i kierowały do właściwych podstron.

- Czy używasz nofollow ? Nie muszę tego chyba tłumaczyć.

Inne czynniki sprawdzane na stronie

Anchor : Pozycjonowanie Warszawa Adres Strony(URL) : Title : Pozycjonowanie Warszawa Description: Pozycjonowanie Warszawa. Firma X oferuje pozycjonowanie i optymalizację strony. Profesjonalizm i skuteczność - to cechy które wyróżniają nas na rynku oferującym pozycjonowanie na terenie Warszawy i okolic. Keywords: Pozycjonowanie, pozycjonowanie warszawa, optymalizacja, Pozycjonowanie stron

Audyt SEO – Czynniki poza serwisem (off site factors)

- czy strona posiada ruch ? Jakiego on jest typu ? Skąd ? – dobrze w tym momencie jest poprosić właściciela o dostęp do statystyk

- jaka jest tematyka strony i co zawiera ? Dla przykładu jeśli trafia mi się strona „warezowa” do audytu należy uwzględnić potencjalne ryzyko zainfekowania takiej strony wirusami (nigdy nie wiadomo, co użytkownik potrafi zostawić na forum w poście) – taka strona otrzymuje tez odpowiednie rankingi w różnego rodzaju serwisach odpowiedzialnych za informowanie o „zaufaniu” do serwisu

- cloaking, doorway’e obniżają ranking strony – więc to też trzeba wychwycić

- profil linków zwrotnych – o ile występują a jeśli tak skąd są – trafiają się klienci, których profile linków wskazują jednoznacznie na używanie XR, SB i SWL …

- czy strona jest zaangażowana w życie „społecznościowe” np twituje, ma profil na FB czy też na G+. Wskazane jest również sprawdzenie czy firma klienta występuje w Google Maps

Bardzo cie proszę o info skąd wiesz o:

– nie liczeniu linków w stopkach

– o tym, że linkujac do wiki podnosimy swój ranking

Moze byc link, itp. mam niezla baze rss z naszymi i zagranicznymi i z tym stwierdzieniem pierwszym nigdzie sie nie spotkalem

@Hicarian: o nieliczeniu linków w stopkach od Kaspara (wypowiedział się w kontekście linków z szablonów WordPressa), co do wiki – nie podałem tego bezpośrednio w tekście, że chodzi o dowolne wiki – moim zdaniem linkowanie do Wikipedii będzie korzystne.

Ale ładnie wszystko opisałeś, konkretny wpis. Co tu można dodać… przydałoby się rozwinięcie kilku kwestii, ale byłby to wtedy już gotowiec do bezpośredniego wykorzystania. Dzięki za wpis.

@Pozycer: napisz co opisać 🙂 może będzie to ciekawy temat do omówienia 🙂

Przydatny artykuł, dzięki.

Mam pytanie jak zobaczyć liczbę zaindeksowanych grafik w zawartości map witryny w G webmasters? Nie widzę tego u siebie mam jedynie zaindeksowane strony.

@Jan: używam wtyczek seo z Yoast.com dzięki czemu wszystko samo się indeksuje 🙂 sprawdź czy przypadkiem nie masz blokady na indeksowanie grafik ?

All in One SEO zastąpiłem SEO Yoast i zauważyłem, że nowe wpisy zdecydowanie dłużej się indeksują (do kilku dni), wcześniej do kilku minut. Przypadek? Czy może zła konfiguracja? Ogólnie wszystko wygląda poprawnie.. Zgred jak to u Ciebie wygląda, miałeś taki problem?

Czy byłbyś na tyle uprzejmy aby udostępnić swoje ustawienia wordpress seo yoast np. z tego bloga ? „Eksport i import ustawień SEO”.

@Mariusz: napisz mi mejla na info@zgred.pl to Ci wyślę.

Wtyczki by Yoast są fajne, niestety „wordpres seo by yoast” gryzie mi się z inną świetną wtyczką pod seo „Easy WP SEO”.

Zgredzie wyśle Ci dzisiaj maila co tam z działałem. I będziemy się wiązać 😛 Umową oczywiście 😉

Co rozumiesz przez „stronę w całości wykonaną w javascript”, bo nie za bardzo potrafię sobie wyobrazić sytuację, gdzie js nie jest używany tylko do ajaxa, albo bajeranckiego ostylowania strony (np strony scrollowane) a tu w obu przypadkach zaindeksować stronę się da elegancko. Z flashem jest o tyle problem, że jeśli ktoś nieumiejętnie zrobi stronę na początku to już nam nic nie pomoże (chyba, że stworzenie strony pod stroną), jeśli jednak robimy dla kogoś stronę od podstaw to można to jak najbardziej pod seo ładnie zrobić.

Nic tylko ikonografikę z tego zrobić. To takie popularne ostatnio : ) Faktycznie dobre podstawy dla specjalistów SEO, którzy pytają „co umieścić w audycie”.

Co do linków w stopce to mam inne doświadczenia. W narzędziach google pokazuje linki z jednego z moich serwisów, a są to linki w stopce.

Wiesiek: przecież nie pisałem, że nie pokazuje tych linków w GWT 🙂

Ech, źle to napisałem, nie chciałem zdradzać swojej największej tajemnicy 😉

Ja kilkoma serwisami i linkami z ich stopek wbiłem frazę do top10.

Udowodnione !

Cezzy ostatnio pisał, że title już nie koniecznie jest liczone „na znaki” i nie musi to być 70 znaków. Może być mniej, może być więcej w zależności od jego szerokości w serpach (512px)

Przykład, 107 znaków w title:

google.pl/search?q=In+thi+till+trill+little+litter+fill!+|+Is+it+illicitly+lil’+lilli!+|+If+I+fill+ill+jill+I’ll+frill+thrill!

@Hardy: tak … ale powiedz mi po co Ci tak długi title ???

Kolejny dobry wpis z cyklu „optymalizacyjnych” 🙂

A czy sitemapy nie lepiej generować automatycznie i za każdym razem jak się coś pojawi to puścić pinga? Można od biedy ustawić crona by pingował co jakiś czas.

@shpyo: to już kwestia jak duży jest serwis … ja uruchamiam na katalogach raz na miesiąc i wystarcza 🙂

Życie trzeba sobie ułatwiać, sitemapa generuje się sama, cron sam pinguje i zapominasz o problemie :). A tak musisz pamiętać, chyba, że masz dużo czasu.

Jestem pod dużym wrażeniem. Wpis na sam początek zaimponował rozbudowaną formą – że aż poszedł do druku i tak chodzi ze mną (w te i wewte), ale lektura na prawdę owocna 🙂

@Sebek: dzięki … choć nie ukrywam że szkic był DUŻO dłuższy 🙂

Bardziej miałem na myśli to, że 70 znaków też nie zawsze się zmieści. Ale masz rację, to pierdoła.

Warto wspomnieć by na czas przeglądania strony wyłączyć JS, cookie, flasha i zmienić agenta na google i sprawdzić stronę oczami robota 🙂

Świetny artykuł… Nie jestem co prawda aż tak obeznana w tym ale małymi kroczkami udało mi się przeanalizować pewne części mojego serwisu i taki malutki raporcik z tego wyszedł 🙂

Teraz tylko wprowadzić poprawki i czekać na efekty 🙂

Coraz dłuższe te Twoje wpisy 🙂

Pomiąłeś description, ale pewnie w audytach dla sklepów konstruujesz odpowiedni opis do kategorii, podkategorii, stron produktowych? Moim zdanie jest to ważne w wynikach wyszukiwania. Szczególnie w sklepie.

Tutaj też dodatkowo rich snippety dla stron produktowych i kategorii jeśli jest taka możliwość.

W grafikach oprócz ALT’ów i nazw plików, warto moim zdaniem wspomnieć o mapie plików graficznych, jakie chcemy indeksować.

Ja się w ogóle spotkałem, z czymś takim, że klient miał zablokowaną indeksację grafik w robots.txt, a ma b.duży sklep w którym grafiki też odgrywają sporą rolę (wyszukiwarka img).

Pisz, pisz więcej, bo konkretne rzeczy piszesz 🙂

A pisałeś kiedyś o projektowaniu kategorii/filtrów w dużym sklepie?

Bardzo ale to bardzo konkretne informacje! Dziękuje bardzo za parę rzeczy o których nie wiedziałem. Bardzo się to teraz przyda 😉

Powinieneś dać tutaj opcję „wersja do druku” żeby można sobie było wydrukować te dłuższe wpisy… A sam tekst bardzo przydatny.

Jest możliwość pobrania tego w PDF – właśnie wdrożyłem 🙂

Dzięki!

Przeczytałam tekst i potwierdził on moje przymuszenia, że nie jest dobrze: „jeśli liczba linków zaindeksowanych jest DUŻO mniejsza od liczby linków w serwisie to może (podkreślam może) oznaczać, że podstrony tego serwisu są słabo, źle albo wcale podlinkowane lub zawierają takie błędy, ze trafiły do supplementala” – właśnie to przerabiam – zmieniłam Sote 4,0 na Sote 6,0 i zaczęły się kłopoty – wcześniej indeksacja przebiegała co do linku – ile przesłanych tyle zaindeksowanych teraz z przesłanych indeksuje się 1/4. Strona ma meta tagi , description produktów, unikalne treści – i google nie chce indeksować. Jak np. sprawdzić – podlinkowanie w produkcie Sote?

Co do słów w adresie url, to też bym dywagował, mam kilka które nei mają przyjaznych linków a mimo to ładnie weszły do topów i tam siedzą, a są to nowe strony.

Sprawdziłem swoją stronę haliskaband.republika.pl SEOoptimer’em i pokazuje mi

Words and Chars 0

Text / HTML Ratio 0,08 %

Podczas gdy SEOquake pokazuje Text/HTML ratio 53.77%

Co może być przyczyną takiej rozbieżności ?

Może któryś soft źle policzył współczynnik?

SEOoptimer na początku pokazał że z treścią wszystko OK, ale wychwycił kilka innych błędów (głównie ALT przy grafice, i IFRAME) Na szybko w notatniku pozmieniałem i wszystko było OK (poza IFRAME z odtwarzacza YT) ale zniknęła treść. Wygląd strony się nie zmienił, nadal wszystko było OK.

Wróciłem do stanu początkowego, poprawiłem jeszcze raz i teraz widzi wszystko.

Niestety nie zachowałem wersji gdzie nie widział treści i nie wiem co na to wpłynęło. SEOquake nie miał problemu z żadną wersją, zawsze wszystko było dobrze.

Seoptimer pomaga ale nie wskazuje, że ma być tak cz inaczej. Każdy optymalizator wskaże, że IFRAME jest błędem. Nie przejmował bym sie tym.

Tekst bardzo przydatny, udało się uzupełnić kilka rzeczy których nie wiedziałem. Czy jest jakiś poradnik jak ustawić dobrze plik robots.txt?

„Najpierw należy zacząć od ?.

Wskazówki dla webmasterów według Google ? aaaaale żarcik ;)” – uwielbiam takie poczucie humoru 🙂