Google jakiś czas temu stwierdziło, że oficjalnie nic nie będzie potwierdzać i informować o wypuszczeniu jakiegokolwiej aktualizacji algorytmu. Nie mniej jednak wypuścili dwie aktualizacje obok siebie. Przy małych srewisach zmiany są praktycznie niezauważalne dopiero przy dużych serwisach zaczyna się to objawiać spadkami.

Aktualizacja Phantom 2 : 3 maj 2015

Aktualizacja Mobile : 21 kwiecień 2015

Tak bliskie wypuszczenie obu aktualizacji stwarza problem interpretacyjny ponieważ „odcięcie” ruchu na urządzeniahc mobilnych (spadek na pozycjach) powoduje niejednokrotnie również spadek na pozycjach „desktopowych”.

Phantom 2 i Panda w jednym

Tak naprawdę Phantom 2 to jednocześnie Panda „pełną gębą” – aktualizacja dotyka strony:

- słaba jakość tekstu (thin content) – i nie chodzi o precle (bo te cześciowo mają się zaczepiscie dobrze)

- kopie artykułów – i tutaj niestety wydaje się być to lekko „buggy” ponieważ obrywa serwis, który artykułów nie kopiował – moim zdaniem Google nie rozwiazało tutaj problemu kto od kogo kopiował i leci serwis, który był wysoko na pozycjach (sprawdzone). Tutaj dość nieciekawa obserwacja – oberwać może artykuł w 100% skopiowany z witryna A jak i ten, który ma zaledwie 20-30% kopii witryny B (taka obserwacja mi się trafiła)

- obrazki, które nie mają podpisu – na przykład serwis może posiadać jakieś skany obrazków do kolorowania dla maluchów bez opisu – te podstrony bardzo mocno „poleciały” w wynikach (tak po 30-50 pozycji -> wynik zbadany w Semstorm)

- zła optymalizacja – duże serwisy mają niejednokrotnei pisane artykuły przez różne osoby (copywriterów), którzy nie znają zasad optymalizacji takich tekstów. Są one wklejane z różnymi zagnieżdżeniami H2, H3 i wytłuszczeń co powoduje, że nie ma jednego schematu optymalizacyjnego dla artykułów

- słaby UX – nawigacja na stronie pod kątem linków wewnętrznych jest po prostu bardzo „niewygodna” – chodzi głównie o nagromadzenie linków wewnętrznych pod artykułem niejednokrotnie nie powiązane ze sobą tematycznie (chodzi o brak spójnego „silosowania” artykułów – czyli np piszemy o zabawkach dla dzieci a pod artykułem jest link wewnetrzny do ubranek)

- przeładowanie serwisu reklamami – tak była taka aktualizacja jakiś czas temu – Phantom 2 powiela tę karę podnosząc ostro poprzeczkę

- problemy techniczne – w przypadku niektórych serwisów zaczyna mieć znaczenie prędkość ładowania, odpowiedzi, błedy 40x oraz 50x. W przypadku zaobserwowania takich błęów (szczególnie uczulam na 40x oraz 50x) trzeba już dodatkowo optymalizować serwer

Przykład spadku ruchu wg Google Search Console (GWT) – spadek ruchu średni ok 25%. Analiza ruchu w Gooel Analytics pokazuje zmianę na współczynniku odrzuceń z 31% do niecałych 7% (ciekawostka), wzrost liczby wyświetleń na stronie – natomiast spadek na ruchu o ok 23-26% (w zależności od medium).

Niestety screenów z GWT/GSC oraz Analytics pokazać nie mogę…

SEMSTORM z pomocą dla Phantom2

Monitorując dane w GWT czy GA nie wszystko da się zauważyć – dlatego sięgnęliśmy do Semstorm, bo zwykły monitoring nie dawał takiego widoku jaki był potrzebny 😉

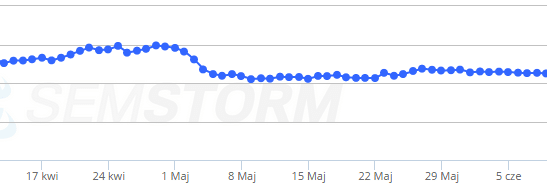

Na wykresie genialnie widać spadek w okolicach 3 maja … Teraz rzut oka lekko na prawo na wskażniki ruchu:

W związku z powyższym należy dokonać przeglądu największych spadków w słowach kluczowych – najlepiej wykonać eksport do excela (czy innego arkusza) i wykonać ręczną analizę oglądając strony, które spadły w wynikach. W badanych serwisach praktycznie wszystkie wyżej opisane problemy występowały: od thin content do błędów z serwerem z uwzględnieniem kopii artykułów i złej optymalizacji serwisu.

Niestety ale tabelki z wykonaną analizą wkleić nie mogę – po prostu za dużo byłoby widać 😉

Zalecenia na przyszłość

W zasadzie nie ma co specjalnie wymyślać strategii jednakże w przypadku dużych serwisów dotykanie wszystkich elementów jednocześnie może nie być wskazane. Dlatego uczulam na:

- nie wykonywać gwałtownych ruchów i nie zmieniać adresów URL (to nic nie da)

- wzbogacić i zmienić treść na serwisach tam gdzie artykuły są skopiowane (wiem, że w przepisach jak coś ugotowac będzie tro trudne)

- sprawdzic koniecznie działanie serwera

- monitorować na bieżąco prędkość ładowania się strony oraz zoptymalizować jej działanie

- wykonać audyt seo, ewentualnie wykonać stosowną optymalizację serwisu

- niejednokrtonie duże serwisu mają dołączone fora – sprawdzić czy nei padło ono ofiarą „szeptanki szemranki” – wtedy trzeba takowe forum oczyścić

- sprawdzić canonicale – tak – czasem zdarza się, że są źle zaimplementowane

Oczywiście to nie wyczerpuje pomysłów na poprawienie serwisu.

Gdyby ktoś chciał więcej poczytać odsyłam do tego artykuł (w języku angielskim): More Findings From Google?s Phantom 2 Update – jest tam dużo więcej a był on dla Mnie inspiracją do napisania tego artykułu.

Obrazek ducha pochodzi z serwisu: http://www.clker.com/clipart-phantom-ghost.html

„Google jakiś czas temu stwierdziło, że oficjalnie nic nie będzie potwierdzać i informować…”

Była jakaś oficjalna informacja na ten temat, czy to Twoja obserwacja?

Było kilka razy… Mówił o tym Matt i kilka razy john

Jakoś przeoczyłem i cały czas liczę na jakieś oficjalne info na temat aktualizacji 😉

Swoja drogą, jeszcze niedawno z takim wyprzedzeniem poinformowali o Mobile Update, a teraz nie potwierdzają żadnych zmian.

Ja u jednego klienta który ma sklep z powieloną treścią też zauważyłem spadek ruchu na przełomie maja i czerwca.

„Wykonać audyt seo” – czytam seo blogi i wszyscy piszą o audytach. Teraz bez nich to już ani rusz.

Wystarczy sprawdzający… Nie musi być pełny

Pierwszy screen z jakiego narzędzia pochodzi?

Barracuda

Zanim się kogoś ukaże należy sprawdzić kto od kogo skopiował, trudno też wszystko traktować jako kopiowanie w złej wierze, przepis czy opis konkretnego produktu jest tu dobrym przykładem

Mam pytanie trochę nie na temat, ale skoro już tu jestem i coś się dowiedziałem to spytam.

Czy ilość komentarzy na blogu lub forum (mając profil) bardzo go wzmacnia, czy skupić się lepiej na pozyskiwaniu nowych profili? A komentować od czasu do czasu to co się ma?

Tak wzmacnia go natomiast na logikę – jeśli komentarzy jest 2-3 to raczej niewiele wnosi to aczkowliek mogą być dłuższe. Z forum jest podobnie bo pytanie i odpowiedź to trochę za mało treści aby to cokolwiek dało. Nie mnije jednak jeśli całośc przekracza 200 znaków to test Kruga powoduje iż tematyka jest znana i link powinien dość dobrze rankować 🙂

Możesz rozwinąć myśl – źle zagnieżdżone H2 itp?

Czy dobrze rozumiem:

Nadużywanie np. słów kluczowych w H2, H3, H4 może powodować spadki?

np.

Tytuł: Sklep Ala – sprawdzamy ofertę i opine

H2 Ala wstęp

H2 Ala oferta

H3 Ala dodatkowe koszty

H3 Ala opinie

Czy przy odpowiedniej długości i jakości tekstu takie H2-h3 mogą być?

Może się tak zdarzyć właśnie jak piszesz – jeśli w Hx będziesz notorycznie wstawiał słowa kluczowe może to być upychanie słów i „polecisz” na pozycjach.

A ostatnio coś się nie zadziało? Około tygodnia temu rewolucje się zrobiły pod frazą nad którą wcześniej pozycjonowałem wywalając dużo serwisów z pierwszej i drugiej storny a na ich miejsce weszło dużo zagranicznych. (Informuje ze fraza ma odpowiednik zarówno w polsce jak i w stanach)

Ta aktualizacja nie była jednak tak wielkim zatrzęsieniem, oberwały strony które faktycznie byłu śmieciowe.

Dziękuję za komentarz. Link usunąłem żeby nie wspierać śmieci

😛

Czy za upychanie słów kluczowych w ALT, lub ich po prostu częste powtórzenia w obrazkach można zaliczyć spadki?

Tak można.

No ale taki np. sklep jak sprzedają telewizory to mają problem w altach. Ciągle musieli by pisać „Telewizor LCD…”

Co w takim przypadku robić. Zostawić alty bez niczego?

No to napiszą – ale każdy alt będzie inny ze względu na typ telewizora, markę. Możn aoczywiscie zostawićpusty – nic nie stoi temu na przeszkodzie 🙂 Jak będziesz to robił sensownie i z głową to nic się nei stanie.

Hej. Mam problem. Od jakiegoś czasu po wpisaniu site:domena.pl wyskakuje mi strona główna w wersji HTTPS. Nie korzystam z SSL, pisalem do administratorów hostingu aby wyłączyć SSL całkowicie. Stwierdzili, że to nie wina serwera. Jak się okazuje w Bingu też zaindeksowana jest wersja HTTPS. Co w tamim przypadku zrobić? preferowana domena jest ustawiona w Google, wpisałem kod przekierowania z HTTPS na HTTP niestety nie pomaga- wyswietla się strona, że hakerzy mogą ukraść dane. Czy użyć do tego narzędzia do usuwania adresów i dodać na nowo z http? help please

Zobacz czy przypadkiem nie ma treści przeniesionej do katalogu private_html. NIe jestem znawcą ale może coś tam siedzi. HTTPS to ewidentna wina serwera bo jest to uruchamiane na serwerze…

1) Zainstaluj SSL – to dla dobra wszystkich bo np. prosty sniffing może pozbawić Cię hasła i loginu do twojej stronki

2) Pewnie masz gdzieś link zewnętrzny do https:// zamiast http:// bo np. ktoś z konkurencji zna tę sztuczkę i zrobił to celowo – dodanie dobrego linku do https zamiast http pokaże w Google wersje z SSL – gorzej jeśli na zapytanie tak wchodzi, jeśli tylko na site: to nie ma się co przejmować ale i tak punkt 1) lepiej zrealizować.

Już jest ok:) po update google samo przeindeksowało. dzieki

Czy mogę prosić o rozwinięcie:

niejednokrtonie duże serwisu mają dołączone fora ? sprawdzić czy nei padło ono ofiarą ?szeptanki szemranki? ? wtedy trzeba takowe forum oczyścić

oraz jak oczyścić forum, aby nie było traktowane jak jeden spam?

Ogólnie widać napływ użytkowników, którzy mają kilka postów, niejedokrotnie nawet 1-2 posty i w profilu widzisz link do strony WWW, w podpisie link do storny WWW i nierzadko juz w pierwszych postach wrzucają linki do jakichś stron WWW. Uzytkownika łątwo rozpoznać bo zazwyczaj nick skłąda się z jakiegoś słowa i mnóstwa cyfr lub całkowicie jest od czapy, patrzy się na mejle. NIe mniej ejdnak nagle w wątku wszyscy nagle reklamują „swoje” usługi lub produkty i robi się farma linków.

Oczyszcza się recznie – banując (tak robię na dwoch forach – skutecznie), można też (co odstrasza) założyć nofollow na wszystkie linki wychodzące. Również skuteczne jest aby nowi użytkownicy moglo dodawać odnośńiki np po 20 podstach lub więcej 😉