Za siedmioma górami, za siedmioma morzami – mieszkał serwis z pierdyliardem podstron. I miał on problemów bez liku a przede wszystkim chciał mieć zaindeksowane wszystkie podstrony, których było dobre kilka milionów.

Dlaczego chciał miec wszystko zaindeksowane ? Bo uparciuch był z niego i wychodził z założenia, że im więcej zaindeksowanych podstron tym większy długi ogon w pozycjonowaniu i tym większy ruch zgarnie z rynku.

Zatem popatrzmy na serwis.

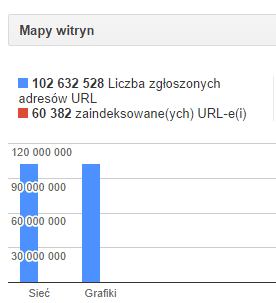

Konstrukcja opiera się na wygenerowaniu wielu podstron po jednej dla każdego produktu w serwisie. Blisko 102 MIO (MIO = miliony) podstron z grafiką oraz tagami ma za zadanie stworzyć ogromny serwis. Komenda „site:dany-serwis.pl” w Googletce zwraca obecnie 489 tys zaindeksowanych podstron i powolutku pnie się to do góry. Można też zauważyć spore wachania zaindeksowanych stron – w momencie gdy rozpocząłem pisać ten wpis zaindeksowanych podstron było 489tys, dzisiaj jest ponad 24 MIO. Ale może to być w każdej chwili zredukowane… Należy przy tym zauważyć, że fluktuacje liczby zaindeksowanych podstron mogą być spowodowane:

- słabym podlinkowaniem serwisu

- serwis jest jeszcze bardzo młody

- słabe linkowanie wewnetrzne

- opisy produktów są bardzo skąpe

- …. i tak dalej

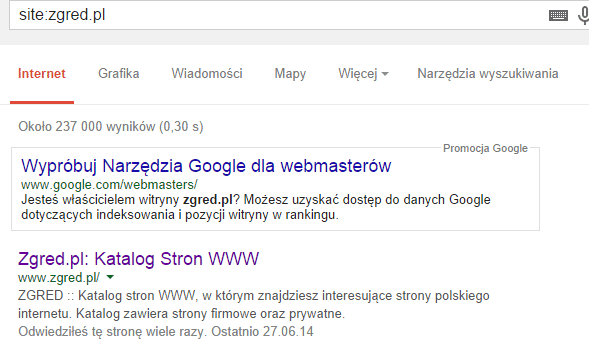

Dla serwisu zgred.pl liczba zaindeksowanych podstron powinna oscylować w granicach 10-12MIO a ile jest tyle widać.

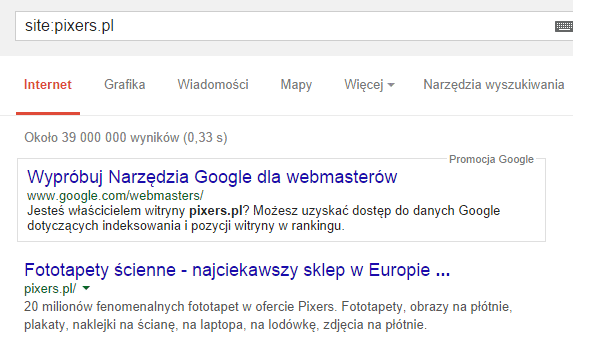

Serwis pixers.pl miał kilka dni temu niecale 240 tys zaindeksowanych podstron, dzisiaj pokazuje 39MIO…

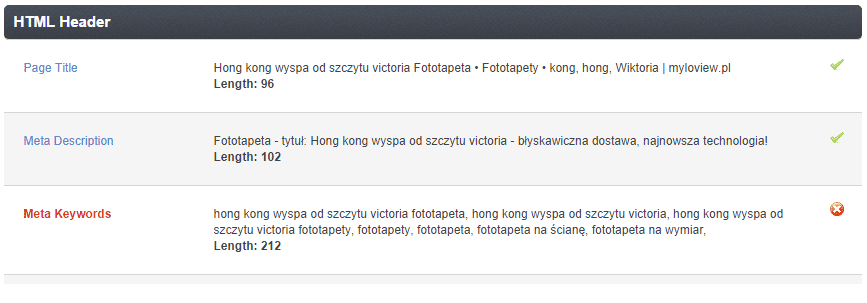

Co jeszcze może być źle wykonane w seriwsie z fototapetami i może dość mocno przeszkadzać w indeksacji ?

- Opis może być masakrycznie skąpy – równie dobrze można powiedzieć, że nie istnieje. Czyli jest to albo krótkie zdanie lub jednowyrazowy opis.

- Fraza „fototapety” powtórzona kilkukrotnie tworząc niezłej „jakości spam” – niby tylko 11-15 razy ale dlatego, że nie ma treści można to uznać za upychanie słów kluczowych

- w nagłówkach meta „bałagan” i upchane słowa kluczowe – niby Google nie bierze tego pod uwagę przy rankowaniu ale jeśli jest tam spam to już niestety bierze…

Umieszczanie na stronei serwisu (nawet w ukrytych pczyciskach) tych samych tekstów technicznych (np o wykonaniu fototapety lub jak ją przykleić), które są powielone pierdyliardy razy na innych fototapetach szkodzi. Oznacza to, że 1% treści to opis produktu natomiast ponad 90% to powielony tekst opisujący fototapetę i techniki wykonania etc… No tak to nie zadziała – może być wzięte z duplicate content i wyszukiwarka wyrzuci wszelkie tego typu podstrony z indeksu lub przesunie do „suplementala”.

Aby urozmaicić opis fototapeta powinna posiadać komentarze – super – na pewno pomoże – pod warunkiem, że nie będą miały tej spamej daty powstania (sic! ale wtopa) czyli nie będzie widać gołym okiem, że sami sobie je wygenerowali…

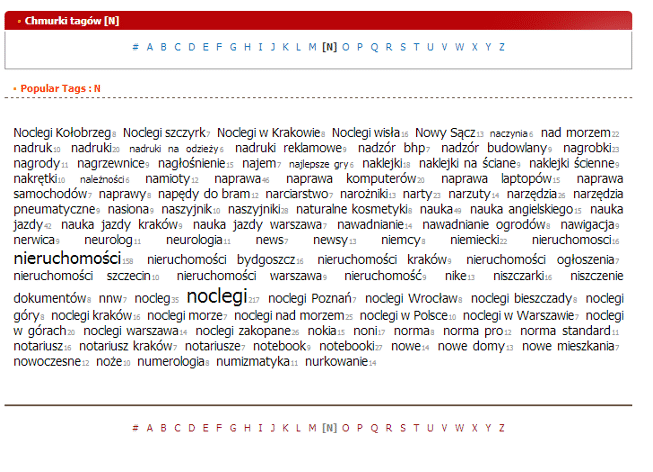

Problemem mogą być też chmury tagów – przy fototapetach właściciele mają zwyczaj wrzucania 20-40 tagów. Możemy mieć tutaj do czynienia z tagami, których konstrukcja powoduje powstawanie dla jednego produktu kilkudziesięciu dodatkowych podstron.

Wnioski tutaj nasuwające się:

- strony z tagami powodują powstanie wielu setek bezwartościowych (z punktu widzenia Google) podstron mogących tworzyć duplikaty w obrębie witryny

- strony odsyłajace w ramach chmury tagów do spisu tagów służą tylko polepszaniu indeksacji co może być łamaniem wskazówek jakościowych

Co zrobić aby zaindeksować wszystkie podstrony ?

- Stworzeniem podstron z tagami tak jak jest to obecnie (tylko, że Google może to utrącić)

- Wykonanie dodatkowego linkowania wewnętrznego z tekstów opisujacych kategorie – długi tekst umieszczony na samym dole (ukryty CSS-em widocznym dla szukajki i użytkownika) powinien pomóc

- Podzielenie serwisu na kilka(naście) map stron i dodanie ich do Narzędzi Google. Map może byc ok 200 sztuk więc mamy pole do popisu. Mapy mogą być: miesięcznie, tygodniowe, dzienne – co powinno przyspieszyć odwiedzanie nowych produktów

- Nierealne jest podlinkowanie wszystkich podstron – należaloby wykonac własny SWL do tego celu 🙂

Teoretycznie (niewskazana opcja) można wykorzystać umieszczenie dodatkowych tekstów np w podkatalogu „porady” i z każdego tekstu wykonać linkowanie wewnetrzne jak to ma miejsce w przypadku kategorii jednakże linków wewnętrznych wykonać 30-50 sztuk – czyli tyle ile się da.

- Można wykonać w stopce serwisu indeksu alfabetu, gdzie po kliknięciu przemiścimy się na stosowną stronę z tagami (na rysunku poniżej taki indeks znajduje się w stopce i jest on dostępny na każdej podstornie serwisu dzięki czemu zwiększamy poziom indeksacji).

Czy takie indeksowanie ma zatem sens ?

NIE. Google samo rozpozna wartościową treść i to co jest zbędne zostanie usunięte z indeksu. Może się zdarzyć też, iż strony z tagami zostaną zakwalifikowane jako stricte wyniki wyszukiwania a te z kolei, zgodnie z wytycznymi Google, nie powinny być indeksowane.

Moim zdaniem skupiłbym się na optymalizacji głównych kategorii seriwsu oraz ich optymalizacją. Pozycjonowanie strony głównej oraz kategorii na główne frazy związane z fototapetami oraz linkowanie wewnętrznie przyniesie więcej korzyści niż indeksowanie wszystkich podstron zwłaszcza, kiedy serwis jest w tak młodym stadium.

Tutaj należy też zauważyć, że przedmiotowy serwis posiada braci (albo siostry jak kto woli) skierowane na inne rynki np brytyjski. Dokładając starań i pozycjonując wszystkie te serwisy będziemy mieli w pewnym momencie samonapędzajacy się mechanizm (niemalże perpetuum niemobile) i przekazywanie mocy pomiędzy serwisami…

Wzmacniając te serwisy (główne strony) oraz kategorie produkty w postaci fototapet same osiągną wysokie pozycje bez konieczności ich linkowania. Ale na to potrzeba czasu i cierpliwosci – oceniam, że po roku czasu będą pierwsze efekty.

Tak więc parcie na zaindeksowanie wszystkiego jest, imho, niepotrzebne.

Jak ktoś ma jakieś inne pomysły zapraszam do dyskusji 🙂

Aktualizacja: przepraszam za zdjecie artykułu i edycję ale na prośbę firmy musiałem dokonać „anonimizacji” tekstu 😉

Zgredzie przeczytaj tekst na spokojnie i popraw literówki. Na przykład: ż enie ma treści możn ato uznać za upychanie słów kluczowych.

Pozdrawiam 🙂

Zaciekawił mnie kawałek na temat tagów, skoro indeksowanie (tagów) nie jest zgodne na dzień dzisiejszy z wytycznymi google, dlaczego wyszukiwarka sama nie „utrąci” możliwości ich indeksowania? Byłoby bardziej czysto w wynikach i przede wszystkim zgodnie z wytycznymi.

Tagi dobrze prowadzone nie szkodzą, tagi przyspamowane – szkodzą. Ot taka różnica, w której każdy seowiec ma inne zdanie 😉

Dla czego twierdzisz, że potrzeba przynajmniej roku?

Dzięki poganianiu indeksacji, Google (w teorii) powinno szybciej ocenić większość contentu i już go rankować na odpowiednich miejscach. Linki linkami. Optymalizacja optymalizacją. Tutaj pewnie Panda by szybko posprzątała 😉

Zgredzie! „Wachania”? Czy Beerbant ma odwiedzić z 0,7 również Ciebie? 🙂

Jak chodzi o pixers to każda fototapeta (zdjecie) istnieje w trzech wersjach dla każdej z grup produktowych – każda ma inny adres, meta i szczątkową treść. Ponadto pixers indeksuje wyniki wyniki wyszukiwania …./fototapety/szukaj/storczyk i coś co wygląda jak wynik wyszukiwania np. …./fototapety/lupe-szukaj-51488844 albo …./fototapety/szukaj-bible-66623172. Z pewnością chodzi o długi ogon.

Oby nie w snach nie nawiedzał z tym 0,7 😉

A moze te wyniki wyszukania są użyteczne i wartościowe ??? 😉 Pixers był jako przykład bo naszedł pod rękę 🙂 O tym, że cały serwis jest źle wykonany nie muszę informować naokoło 😛

Już nie róbcie ze mnie takiego killera 😉

hmmm to jak wytłumaczycie obecność w topach stron np. sklepów z pościelą gdzie duplikat duplikata pogania? wszystkie warianty czyli po kilka rozmiarów i kilkanaście kolorów danego rozmiaru – każde ma swoją osobną podstrone i wiszą, dobrze sie mają 🙂