Na podstawie dwóch ostatnich artykułów związanych z algorytmem Pingiwna, mając dostęp do konta basic w serwisie Ahrefs.com poczyniłem pewne obserwacje zgodnie z treścia wspomnianych artykułów:

- https://www.zgred.pl/blog/spojrzenie-na-algorytm-pingwina-innymi-oczami

- https://www.zgred.pl/blog/zmiany-algorytmu-google-moje-widzimisie-stanowisko

Bazując w szczególności na artykułach z Ahrefs dokonałem obserwacji na kilku serwisach. Zakładam (pewnie powiecie, że błędnie ale z reguły SEOfcy stosują te same strategie), że strategie SEO są do siebie zbliżone. Nie analizowałem jakości linkowania ! Serwisy w większości zoptymalizowane.

1. Dwa serwisy pozycjonowane na niezbyt szeroki long-tail (ok 30-40% fraz) + strona główna + rownomiernie rozłożone frazy – całość zanotowała duże wzrosty

2. Serwis pozycjonowany na wąski long-tail + bardzo mocno strona główna + nierownomiernie rozłożone frazy – całość zanotowała duże spadki – można by rzec, ze odcięte na amen a serwis był „topowy”

3. Serwis pozycjonowany na szeroki long-tail + strona główna + rownomiernie rozłożone frazy – całość pozostała na wysokich pozycjach – serwis był „topowy”

4. Serwis pozycjonowany na niezbyt szeroki long-tail + strona główna + równomiernie rozlożone frazy – całość się buja od update’u algorytmu w zakresie +/- 50-80 pozycji – serwis był „topowy”

W chwili obecnej mocniej usiadłem do pozycjonowania typu long-tail … czyli od zera zaprojektowanie linkowania, opracowanie „jako takiej” strategii. Efekty zapewne będą widoczne dopiero za kilka/kilkanaście tygodni 🙁

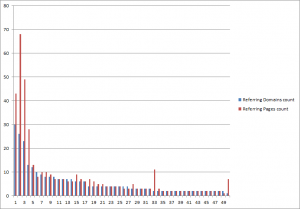

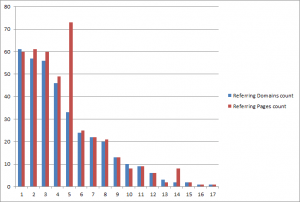

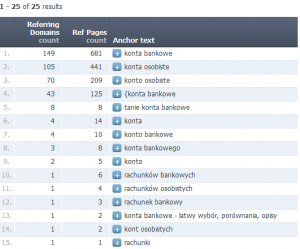

Aktualizacja: 8.05.2012 – mała aktualizacja – dodaję rozkład anchorów na ministronkę (8 podstron) z ofertą kont bankowych. Strona stara, pozycjonowana, wystrzelona za STOgórogrodzie 😉 90% anchorów na stronę główną.

Po przeczytaniu tego rozumiem, że lepiej przy tym update wyszli ci, którzy nie wbijali się na jakąś konkretną frazę i to głównie ze strony głównej, tylko tacy trochę przypadkowo wbici, gdzie linkowane było co popadnie (różne URLe) na mnóstwo różnych fraz? Dobrze rozumiem?

źle. tacy co porządnie zadbali o long-taila 🙂 i nie słuchali sie do końca klientów … ehh …

Czyli dla przykładu jak ktoś pozycjonował dla strony załóżmy jubilerskiej (nie mam takiej, dlatego to wybrałam), to jeśli pozycjonował ją na biżuteria i ciągle linkował do głównej to wyszedł na tym znacznie gorzej niż ktoś, kto robił oprócz „biżuteria” dla głównej, także sporo na „biżuteria srebrna”, „biżuteria ślubna” itd. oraz linkował do podstron… tak, czy jeszcze inaczej trzeba to rozumieć?

Dokładnie 🙂

Aha 😉 dzięki za wyjaśnienie 😉 pytałam, bo jak się tylko tak z doskoku czyta a nie zajmuje SEO zawodowo, to ciężko czasami zrozumieć (albo być pewnym, że się dobrze rozumie) takie analizy.

Co do słuchania Klientów… no cóż – zwykle trzeba się uprzeć albo odesłać z kwitkiem, bo później się to tak kończy (i to nie tylko w SEO). Ech…

Mogę częściowo potwierdzić Twoje wnioski. Mam 5 stron, w których linkowałem różne podstrony i lekko stronę główną. Wszystkie po update zanotowały spore wzrosty.

Fajny wpis Zgred, oparty na faktach. Kolejny dowód na to, że SEO będzie niedługo droższe niż obecnie. „Niestety” małe firmy – i SEO, i Klienci – nie dadzą rady. Tak ja to wstępnie widzę.

no to Pawel bedzie co robic

Tylko jedna rzecz mnie ciekawi – przy białym SEO, przy nie uzywaniu SWLi, xRumerów czy publicznych precli przyznam, że nie zaobserwowałem wymienoionych sytuacji – co skłania mnie do stwierdzenia, że przy większej różnorodności fraz łatwiej jest ukryć linki z precli, katalogów, xRumerów itp. Powtarzam – ja nie zanotowałem spadków – w każdym z opisanych przez Ciebie przypadków…. hm …

Hm… z tym, że SEO będzie droższe – no cóż, jest kilka rzeczy, które trzeba wziąć pod uwagę w kalkulacji:

– CPC w AdWords też z roku na rok znacząco rośnie,

– dobre SEO (nie w wykonaniu łebków linkujących jak i gdzie popadnie) i tak musiało dotąd kosztować, bo to dużo pracy i inwestycji,

– inne formy reklamy w sieci też się dość mocno cenią,

– reklama poza Internetem (ulotki, banery itp.) też zawsze kosztowała, a jakoś firmy się reklamowały (małe też).

Więc może jednak jakiegoś strasznego załamania nie będzie tylko w końcu do ludzi dotrze, że dobry specjalista od SEO to ktoś z dużą wiedzą i że pozycjonowanie to ciężka praca. Na razie ciężko cokolwiek wieszczyć. Choć przyznam, że w kuluarach różnych szkoleń słychać narzekania, iż obecnie czasami lepiej opłaci się nic nie robić niż inwestować w AdWords czy banery, bo więcej kosztują niż generują przychodu.

Co do spadków – u mnie ich nie było, ale też stron nikt na żadne trudne frazy nie pozycjonował (było tylko proste dodanie do kilku katalogów plus taka z grubsza optymalizacja robiona pomiędzy kodowaniem aplikacji webowych /robots=”noindex,nofollow,noarchive” lub googlebot=none” – to bardziej moja działka/). Na szczęście dla serwisów, które mam pod opieką akurat długi ogon jest bardziej naturalny niż jakakolwiek konkretna fraza… oczywiście od niejednej „wielkiej” firmy pozycjonerskiej przychodziły oferty na wbicie do top 5 lub top 10 na frazy, gdzie strona sama wchodzi, a liczyli sobie za to jak za frazę z gatunku „kredyty” /o jednej firmie z Poznania już było… też umeiraliśmy ze śmiechu czytając ich ofertę pełną bzdur po ich darmowej „analizie SWOT”/. Tak więc mnie pingwin nie dotknął, a raczej nawet lekko skoczyło w górę na co ważniejsze frazy… pytanie na jak długo 😐 bo przyznam, że każdego dnia sprawdzając czy strona nadal w top 3 zastanawiam się, czy zobaczę ją w top 10 czy poza setką… raz już mi jedną stronę wywaliło na dwa tygodnie w niebyt (bez żadnego update algorytmu), ale sama wróciła.

Grażynko – twoje posty zaczynają trafiac do spamu 😀 Aksimet się poznał 😛

No widzisz 😀 to je eksmituj ;-P a tak serio, to czasami między specjalistami głos laika bywa pożyteczny, bo przez idiotyczne pytania nieświadomie coś podpowie 🙂 nie wiem jak jest w Waszej pracy, ale mnie już nieraz olśniło w taki sposób.

Koniec dygresji – już nie przeszkadzam 😉

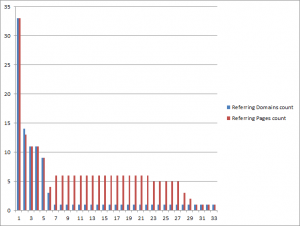

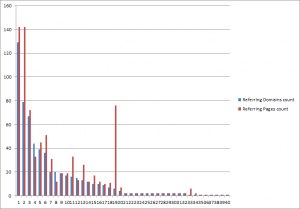

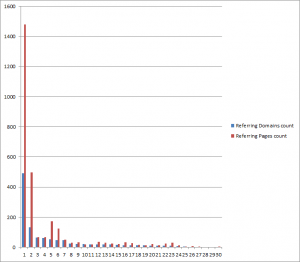

Rozumiem, że na osi X znajdują się kolejne podstrony? Dobre zestawienie, pokazuje co nie co. Przydałaby się jeszcze informacja ile podstron mają te serwisy (jaki % podstron był linkowany)

Kolejne podstrony czy kolejne frazy?

Nie rozumiem pytania ?

Chodzi o upewnienie się co przedstawiają osie X wykresów 🙂

oś Y – wiadomo – liczba poszczególnych elementów, oś X – po prostu iteracja wystąpienia od 1 do …. iluś tam.

A jak wytłumaczyć spadki o 2-8 pozycji na wszystkie linkowane frazy? Chodzi o sklep, linkowana główna i wszystkie podstrony kategorii. Podstrony produktów linkowane sporadycznie, dużo wchodziło samo ciągnąć sok z kategorii.

Co prawda nie są to odpukać 🙂 spadki na 30 stronę ale zawsze trochę boli.

A co zrobić z klientem zajmującym się „pompowaniem kół w Poznaniu”?

Robi jedną konkretną usługę.

uważałbym aby nie spalić domeny. Mam kilku takich klientów i jak na razie jest OK.

Ja mam domenę z podobnym rozkładem fraz jak zamieściłeś w aktualizacji. Główna pozycjonowana fraza spadła o 3 pozycje, dwie następne o kilkanaście, reszta w kosmos. Z tym, że tematyka dużo łatwiejsza.

Ja także poczytałem trochę i opisałem na potwierdzić zatem mogę stwierdzenie zgreda „wąski long-tail + bardzo mocno strona główna + nierownomiernie rozłożone frazy ? całość zanotowała duże spadki”

A jak myślicie, czy teraz pozycjonowanie na kilkanaście anchorów przyniesie wymierne korzyści dla strony która poleciala? Teraz pozycjonowałem ją na 2-3 a dodałbym jeszcze z 5 anchorów.

Potwierdzam te teorie. Stronka moja pozycjonowana na stronę główna, słabo na podstrony, tylko na parę głównych fraz. Przed wprowadzeniem pingwina, na 2 miejscu w Google.uk. Po wprowadzeniu nowego algo 70 pozycja :(. Ale ponoć Google walczy ze spamem, a jak się to ma do tego, ze teraz będziemy walić linkami ostro po podstronach?

Już widzę ten śmietnik 🙂

Żeby nie było tak klarownie to zamieszam 🙂

Dwie strony, obie pozycjonowane podobnie: praktycznie tylko strona główna, z głównym naciskiem na jedną frazę.

Jedna strona jest bez zmian top1 na „swoją” frazę, druga przeprowadziła się na 35 stronę.

Jedyna różnica jaka mi przychodzi do głowy to wiek domen; ta pokrzywdzona jest dużo starsza.

Test bardzo dobry !

– tutaj zauważyłem jeszcze różne wyniki przy różnym linkowaniu wewnętrznym oraz ilości podstron.

Proste serwisy – 10 podstron na HTML dostały po głowie na maxa

Serwisy na WP z mocnym wewnętrznym linkowaniem oraz ilością podstron 20+ dostały lekko a w zasadzie się tylko zahuśtały …

Walenie w główną nie jest wskazówką. Kilka moich stron 99% na główną poszło w górę 2 w niebyt. Przejrzałem i przeanalizowałem co mają za linki strony, które wyskoczyły na updacie algo. Wniosek – więcej stron .pl a mniej anglo bazujacych na expression czy na konkurencji wordpressa, większe zróżnicowanie anchorów – to fakt. Ale z tym nasyceniem na stronę główną to się nie zgadzam.